この記事を書いた人

・AI×ブログ運営に挑戦中!

・ ChatGPT・生成AIで記事作成を研究

・ブログの効率化&収益化を発信!

「AI×ブログ」の可能性を探求し、学びをシェア!

2024年10月、画像生成AI「Stable Diffusion」に待望の新バージョン「Stable Diffusion 3.5 モデル」が登場しました。

このアップデートにより、手や顔の自然な描写、生成速度の最適化、カスタマイズの自由度などが大きく向上。

初心者はもちろん、プロのクリエイターにもおすすめできるほどの完成度になっています。

この記事では、Stable Diffusion 3.5の進化ポイントや各モデルの違い、導入方法、効果的な使い方まで徹底的に解説します!

目次

1. Stable Diffusionの進化と3.5モデルの位置づけ

Stable Diffusionは、OpenAIなどと並ぶ画像生成AIの代表格で、以下のようなバージョンを経て進化してきました。

- 1.x系(1.4 / 1.5):軽量かつ安定。LoRAとの相性が良くカスタマイズしやすい。

- 2.x系:大規模アップグレードで現実感向上。ただし扱いがやや難しい。

- SDXL(3.0相当):高解像度・複雑構図に強く、商用利用にも対応。

- 3.5系(最新):精度・速度・柔軟性の全方位進化を実現。

Stable Diffusion 3.5モデルは、従来の使いやすさを維持しながら、高精細な出力と柔軟なカスタマイズ性を両立した“バランス型の決定版”です。

2. Stable Diffusion 3.5の主な特徴とメリット

① 画像品質の飛躍的向上

- 顔・手・指などの描写が自然になり、違和感が激減

- 背景の歪み・ノイズが軽減

- プロンプトへの反応精度が向上(意図した構図や表情が出やすい)

旧モデルでありがちだった「指が6本」「顔が歪む」などの現象が大幅に改善!

② 速度&動作の最適化

- 3つのバリエーション(Medium / Large / Large Turbo)で構成

- MediumモデルはVRAM 6〜8GB程度でも動作可能

- Large Turboはプロ向け高解像度画像を高速生成可能

PCスペックや用途に応じて最適な「stable diffusion 3.5 モデル」を選べるのが魅力!

③ カスタマイズ性の自由度アップ

- Hugging Faceからダウンロード可能(Stability AI公式)

- LoRA、ControlNet、Textual Inversionにも対応

- SDXL向けツール(ComfyUIなど)との互換性も強化

3. モデルバリエーションの違いと用途

| モデル名 | 特徴 | 推奨用途 |

|---|---|---|

| Medium | 軽量&高速 | VRAM 6〜8GBのミドルスペックPC向け |

| Large | バランス型 | 高品質な静止画生成を快適に |

| Large Turbo | 最速&高精度 | 商用利用・大量出力・プロユース向け |

迷ったら「Large」モデルが無難。まずは「Medium」で試してみるのも◎

4. 導入方法(Web UI/ComfyUI対応)

手順①:モデルファイルをダウンロードする

Stable Diffusion 3.5モデルは、以下の公式配布元から無料で入手できます。

- サイトにアクセスし、「Stable Diffusion 3.5」モデルの中から希望のバリエーション(Medium / Large / Large Turboなど)を選択

.safetensors形式(推奨)または.ckpt形式のモデルファイルをダウンロード

.safetensorsは安全で高速に読み込める形式のため、特に理由がなければこちらがおすすめ!

ファイルサイズは約5GB前後あるため、Wi-Fiなど安定した回線環境でのダウンロードを推奨します。

手順②:モデルファイルを指定フォルダに配置

ダウンロードしたファイルは、使用するツールに応じて決められたフォルダに設置します。

AUTOMATIC1111 Web UIを使う場合:

stable-diffusion-webui/models/Stable-diffusion/このフォルダに .safetensors や .ckpt ファイルをそのまま入れればOKです。

ComfyUIを使う場合:

ComfyUI/models/checkpoints/こちらの「checkpoints」フォルダにモデルを設置します。フォルダが存在しない場合は自分で作成して問題ありません。

モデル設置後はUIの再起動を忘れずに。表示されないときは「モデル再読み込み」を実行しましょう。

手順③:UI上でモデルを選択して起動する方法【AUTOMATIC1111 Web UI編】

- ブラウザで

localhost:7860(ローカル)またはGoogle Colab上のWeb UIを開く - 画面上部または左側の「Checkpoint」ドロップダウンリストをクリック

- 手順②で配置したモデル名が表示されるので、使用したいモデルを選択

- 数秒〜十数秒ほど待つとモデルが自動的にロードされます

- モデルのロードが完了したら、プロンプトを入力して「Generate」をクリックすれば画像生成開始!

モデル切り替え後は一度「Generate」を押して初期ロードを行いましょう。

表示されない場合は「Settings → Reload Checkpoints」で再読み込みできます。

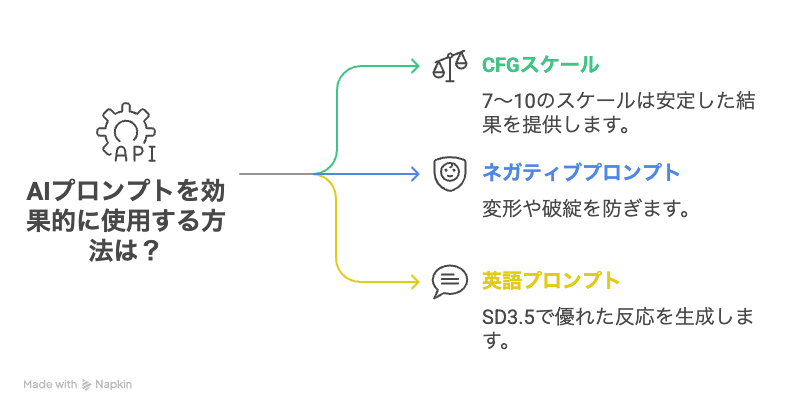

5. 効果的な使い方とプロンプトのコツ

- CFGスケールは 7〜10 あたりが最も安定

- ネガティブプロンプトで「変形・破綻」を防止

- SD3.5では英語プロンプトの反応が非常に良好

LoRAやControlNetとの組み合わせで、自分だけのスタイルを追求可能!

6. ライセンスと商用利用の注意点

Stable Diffusion 3.5は Stability AI Community License に基づいて提供されています。

- 商用利用OK(ただし一部制限あり)

- 改変・再配布も条件付きで可

- 違法・不適切な用途には使用禁止

7. 他のAI画像生成モデルとの比較(簡易)

| 項目 | Stable Diffusion 3.5 | Midjourney | DALL·E 3 |

|---|---|---|---|

| カスタマイズ性 | ◎(最高) | △ | △ |

| 導入コスト | 無料 | 有料 | 有料 |

| 解像度・精度 | ◎ | ◎ | ◯ |

| 拡張性(LoRA等) | ◎ | × | × |

自分で“育てる”楽しみや自由度を求めるなら、SD3.5一択です。

まとめ:Stable Diffusion 3.5は今使うべき最新モデル!

- 最新のStable Diffusion 3.5モデルは、品質・速度・カスタマイズ性すべてが進化

- 初心者にも扱いやすく、プロにも耐える実力を持つ

- Hugging Faceで入手→数分で使い始められる

- 自作LoRAやControlNetとの組み合わせで無限の表現が可能!

画像生成をこれから始める方も、これまで旧モデルで満足できなかった方も、「3.5モデル」で劇的な変化を体感できます。